Boosting 和 Adaboost 的关系和区别是什么? - 知乎

2015年11月20日 · boosting 是一种将弱分类器转化为强分类器的方法统称,而adaboost是其中的一种,采用了exponential loss function(其实就是用指数的权重),根据不同的loss function还可以有其他算法,比如L2Boosting, logitboost... 还有adidas跑鞋上的boost很不错,脚感一流,可以一 …

知乎,让每一次点击都充满意义 —— 欢迎来到知乎,发现问题背 …

知乎是一个发现问题背后世界的平台,让每一次点击都充满意义。

从偏差和方差的角度解释bagging和boosting的原理 - 知乎

boosting从优化角度来看,是用forward-stagewise这种贪心法去最小化损失函数,由于采取的是串行优化的策略,各子模型之间是强相关的,于是子模型之和并不能显著降低variance。所以说boosting主要还是靠降低bias来提升预测精度。 参考

为什么说bagging是减少variance,而boosting是减少bias? - 知乎

Boosting 则是迭代算法,每一次迭代都根据上一次迭代的预测结果对样本进行加权,所以随着迭代不断进行,误差会越来越小,所以模型的 bias 会不断降低。这种算法无法并行,例子比如 Adaptive Boosting. ===== 2015.2.23 修改: stochastic gradient boosting 可以并行

谁能通俗的讲讲Gradient Boost和Adaboost算法是啥? - 知乎

梯度提升和AdaBoost是比较复杂的算法。要通俗,那只能抛开具体的数学不讲,找个日常生活的例子来类比了。

Windows 10 有必要升级为 Windows 11 吗? - 知乎

想要升级win11的友友们,如果拿不定主意可以先看看我这篇11月10号的测评。 PS:当时是刚一出来我就测评了一下,所有的体验仅属当时的个人观点,现在有很多bug已经修复了,大家理性看待,不喜划走.....

机器学习算法中GBDT与Adaboost的区别与联系是什么? - 知乎

Boosting算法特征如下:通过将一些表现效果一般(可能仅仅优于随机猜测)的模型通过特定方法进行组合来获得一个表现效果较好的模型。 从抽象的角度来看,Boosting算法是借助convex loss function在函数空间进行梯度下降的一类算法。

word怎么在数学公式后面加序号? - 知乎

知乎,中文互联网高质量的问答社区和创作者聚集的原创内容平台,于 2011 年 1 月正式上线,以「让人们更好的分享知识、经验和见解,找到自己的解答」为品牌使命。知乎凭借认真、专业、友善的社区氛围、独特的产品机制以及结构化和易获得的优质内容,聚集了中文互联网科技、商业、 …

基于树的adaboost和Gradient Tree Boosting区别? - 知乎

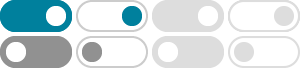

谢邀。 直接参考Machine Learning:A Probabilistic Perspective(MLAPP)的16.4节——Boosting。 该节概括了几种常用的boosting方法,包括L2Boosting、Gradient Boosting、Adaboost、LogitBoost(黑体部分就是题目中提到的两种方法,至于weaker learner是不是用树,不是很重要),下表摘自MLAPP 14.6.1节

支持向量机(SVM)——原理篇 - 知乎

2024年10月15日 · 目录 SVM简介 线性SVM算法原理 非线性SVM算法原理. SVM简介. 支持向量机(support vector machines, SVM)是一种二分类模型,它的基本模型是定义在特征空间上的间隔最大的线性分类器,间隔最大使它有别于感知机;SVM还包括核技巧,这使它成为实质上的非线性 …